1 Scaling Law:实验科学的产物

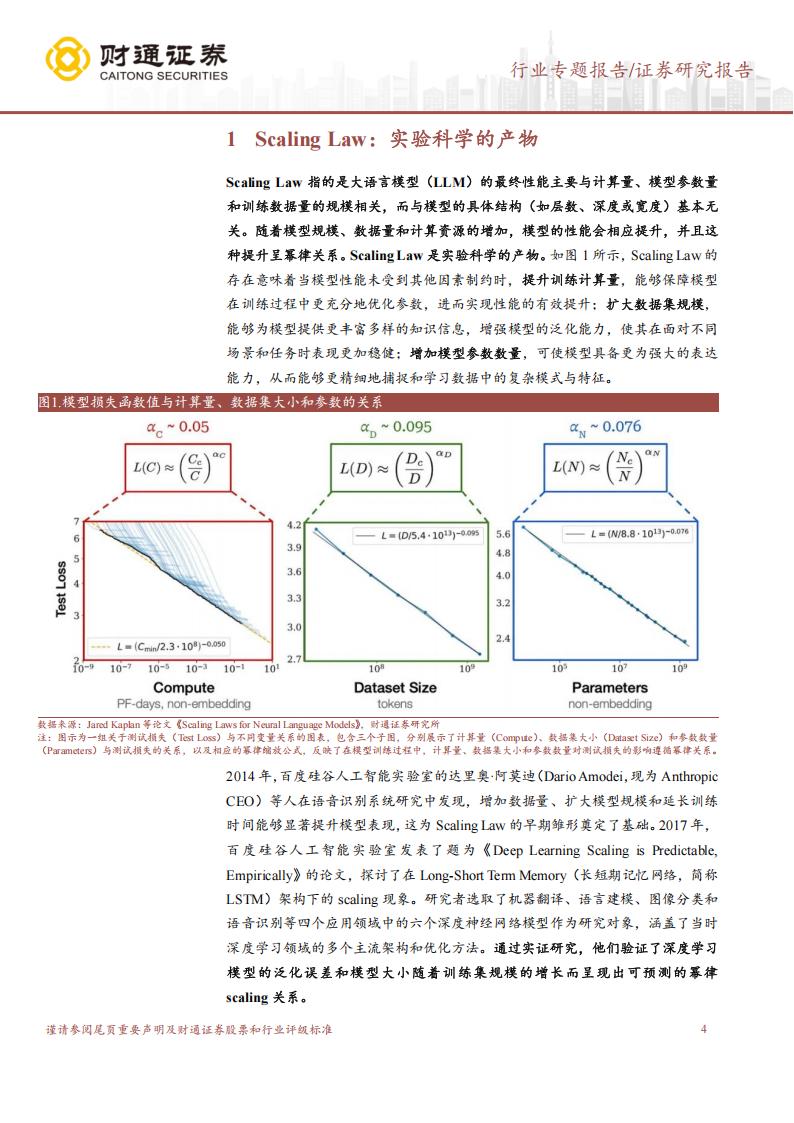

Scaling Law指的是大语言模型(LLM)的最终性能主要与计算量、模型参数量和训练数据量的规模相关,而与模型的具体结构(如层数、深度或宽度)基本无关。随着模型规模、数据量和计算资源的增加,模型的性能会相应提升,并且这种提升呈幂律关系。Scaling Law是实验科学的产物。如图1所示,Scaling Law的存在意味着当模型性能未受到其他因素制约时,提升训练计算量,能够保障模型在训练过程中更充分地优化参数,进而实现性能的有效提升;扩大数据集规模,能够为模型提供更丰富多样的知识信息,增强模型的泛化能力,使其在面对不同场景和任务时表现更加稳健;增加模型参数数量,可使模型具备更为强大的表达能力,从而能够更精细地捕捉和学习数据中的复杂模式与特征。

本文来自知之小站

PDF报告已分享至知识星球,微信扫码加入立享3万+精选资料,年更新1万+精选报告

(星球内含更多专属精选报告.其它事宜可联系zzxz_88@163.com)